Voorstel voor regelgevingskader voor kunstmatige intelligentie

De Commissie stelt het allereerste wettelijke kader voor AI voor, dat de risico's van AI aanpakt en Europa positioneert om wereldwijd een leidende rol te spelen.

Het regelgevingsvoorstel is bedoeld om AI-ontwikkelaars, -implementators en -gebruikers duidelijke vereisten en verplichtingen te bieden met betrekking tot specifieke toepassingen van AI. Tegelijkertijd streeft het voorstel ernaar de administratieve en financiële lasten voor bedrijven, met name kleine en middelgrote ondernemingen (kmo's), te verminderen.

Het voorstel maakt deel uit van een breder AI-pakket, dat ook het bijgewerkte gecoördineerde plan voor AI omvat. Samen zullen het regelgevingskader en het gecoördineerde plan de veiligheid en fundamentele rechten van mensen en bedrijven garanderen als het gaat om AI. En ze zullen de opname, investeringen en innovatie in AI in de hele EU versterken.

Waarom hebben we regels voor AI nodig?

Een zorgwekkend voorbeeld is de moeilijkheid om de redenatie achter het besluitvormingsproces, de voorspellingen en de daaropvolgende acties van een AI-systeem te begrijpen. Bijgevolg kan deze ondoorzichtigheid de evaluatie belemmeren van de vraag of iemand onrechtvaardig is behandeld, zoals bij wervingsprocessen of aanvragen voor openbare voorzieningen.

Hoewel de huidige wetgeving enige waarborgen biedt, speelt deze onvoldoende in op de specifieke uitdagingen die AI-systemen kunnen introduceren.

De voorgestelde regels zullen:

- risico's aanpakken die specifiek worden gecreëerd door AI-toepassingen;

- een lijst met toepassingen met een hoog risico voorstellen;

- duidelijke vereisten stellen voor AI-systemen voor toepassingen met een hoog risico;

- specifieke verplichtingen definiëren voor AI-gebruikers en aanbieders van toepassingen met een hoog risico;

- een conformiteitsbeoordeling voorstellen voordat het AI-systeem in gebruik wordt genomen of op de markt wordt gebracht;

- handhaving voorstellen nadat een dergelijk AI-systeem op de markt is gebracht;

- een bestuursstructuur op Europees en nationaal niveau voorstellen.

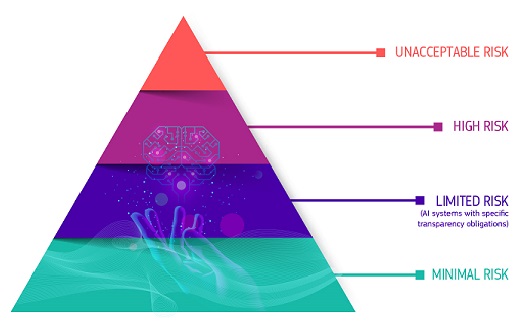

Het regelgevingskader definieert 4 risiconiveaus in AI:

Onacceptabel risico

Alle AI-systemen die als een duidelijke bedreiging voor de veiligheid, het levensonderhoud en de rechten van mensen worden beschouwd, worden verboden, van sociale scores door overheden tot speelgoed met spraakassistentie dat gevaarlijk gedrag aanmoedigt.

Hoog risico

AI-systemen die als hoog risico worden geïdentificeerd, omvatten AI-technologie die wordt gebruikt in:

- kritieke infrastructuren (bijv. transport), die het leven en de gezondheid van burgers in gevaar kunnen brengen;

- educatieve of beroepsopleidingen, die de toegang tot onderwijs en het professionele verloop van iemands leven kunnen bepalen (bijv. scores van examens);

- veiligheidscomponenten van producten (bijv. AI-toepassing bij robotondersteunde chirurgie);

- werkgelegenheid, beheer van werknemers en toegang tot zelfstandig ondernemerschap (bijv. CV-sorteersoftware voor wervingsprocedures);

- essentiële particuliere en openbare diensten (bijv. kredietscores die burgers de mogelijkheid ontzeggen om een lening te krijgen);

- rechtshandhaving die de fundamentele rechten van mensen kan aantasten (bijv. evaluatie van de betrouwbaarheid van bewijs);

- migratie-, asiel- en grenscontrolebeheer (bijv. verificatie van de authenticiteit van reisdocumenten);

- rechtspraak en democratische processen (bijv. toepassing van de wet op een concrete reeks feiten).

AI-systemen met een hoog risico zijn onderworpen aan strikte verplichtingen voordat ze op de markt kunnen worden gebracht:

- adequate systemen voor risicobeoordeling en -beperking;

- hoge kwaliteit van de datasets die het systeem voeden om risico's en discriminerende uitkomsten te minimaliseren;

- registratie van activiteiten om de traceerbaarheid van resultaten te garanderen;

- gedetailleerde documentatie met alle informatie die nodig is over het systeem en het doel ervan, zodat autoriteiten de naleving ervan kunnen beoordelen;

- duidelijke en adequate informatie aan de gebruiker;

- passende menselijke toezichtmaatregelen om risico's te minimaliseren;

- hoog niveau van robuustheid, beveiliging en nauwkeurigheid.

Alle biometrische identificatiesystemen op afstand worden als hoog risico beschouwd en zijn onderworpen aan strikte vereisten. Het gebruik van biometrische identificatie op afstand in openbaar toegankelijke ruimtes voor rechtshandhavingsdoeleinden is in principe verboden.

Nauwe uitzonderingen zijn strikt gedefinieerd en gereguleerd, zoals wanneer nodig om te zoeken naar een vermist kind, om een specifieke en dreigende terroristische dreiging te voorkomen of om een dader of verdachte van een ernstig strafbaar feit op te sporen, te lokaliseren, te identificeren of te vervolgen.

Dergelijk gebruik is onderworpen aan toestemming van een rechterlijke of andere onafhankelijke instantie en aan passende beperkingen in tijd, geografisch bereik en de doorzochte databases.

Beperkt risico

Beperkt risico verwijst naar AI-systemen met specifieke transparantieverplichtingen. Bij het gebruik van AI-systemen zoals chatbots moeten gebruikers zich ervan bewust zijn dat ze met een machine interacteren, zodat ze een weloverwogen beslissing kunnen nemen om door te gaan of een stap terug te doen.

Minimaal of geen risico

Het voorstel staat het gratis gebruik van AI met minimaal risico toe. Dit omvat toepassingen zoals AI-enabled videogames of spamfilters. De overgrote meerderheid van de AI-systemen die momenteel in de EU worden gebruikt, vallen in deze categorie.

Noteer

De AI-wet belooft een evenredige risicogebaseerde aanpak die alleen regelgevende lasten oplegt wanneer een AI-systeem waarschijnlijk hoge risico's voor fundamentele rechten en veiligheid oplevert. De regelgeving is gericht op specifieke sectoren en toepassingen en is verschoven van het binaire kader van laag risico versus hoog risico dat werd voorgesteld in het Witboek van de Commissie over AI naar een risicokader met vier niveaus, dat risico's in vier categorieën indeelt:

- 'onaanvaardbare risico's' die leiden tot verboden praktijken;

- 'hoge risico's' die een reeks strenge verplichtingen in gang zetten, waaronder het uitvoeren van een conformiteitsbeoordeling;

- 'beperkte risico's' met bijbehorende transparantieverplichtingen;

- 'minimale risico's', waarbij belanghebbenden worden aangemoedigd om gedragscodes op te stellen, ongeacht of ze in de EU of een derde land zijn gevestigd.

De systemen die worden beschouwd als systemen met een hoog of onaanvaardbaar risiconiveau - bijvoorbeeld systemen die worden gebruikt bij sociale scores of systemen die omgaan met kinderen in de context van respectievelijk persoonlijke ontwikkeling of onderwijs, zullen een belangrijk punt zijn dat door het Parlement en de Raad wordt overwogen.

De hoop is dat deze aanpak het toezicht op regelgeving beperkt tot alleen gevoelige AI-systemen, wat resulteert in minder beperkingen op de handel in en het gebruik van AI binnen een interne markt. De AI Act belooft een evenredige risicogebaseerde aanpak die alleen regelgevende lasten oplegt wanneer een AI-systeem waarschijnlijk hoge risico's voor fundamentele rechten en veiligheid oplevert.

De regelgeving is gericht op specifieke sectoren en toepassingen en is verschoven van het binaire kader van laag risico versus hoog risico dat werd voorgesteld in het Witboek van de Commissie over AI naar een risicokader met vier niveaus, dat risico's in vier categorieën indeelt:

- 'onaanvaardbare risico's' die leiden tot verboden praktijken;

- 'hoge risico's' die een reeks strenge verplichtingen in gang zetten, waaronder het uitvoeren van een conformiteitsbeoordeling;

- 'beperkte risico's' met bijbehorende transparantieverplichtingen; en

- 'minimale risico's', waarbij belanghebbenden worden aangemoedigd om gedragscodes op te stellen, ongeacht of ze gevestigd zijn in de EU of een derde land.

De systemen die als hoog of onaanvaardbaar risicovol worden beschouwd – bijvoorbeeld systemen die worden gebruikt in sociale scores of systemen die interacteren met kinderen in de context van persoonlijke ontwikkeling of onderwijs, respectievelijk – zullen een belangrijk punt zijn dat door het Parlement en de Raad wordt overwogen. De hoop is dat deze aanpak het toezicht op de regelgeving zal beperken tot alleen gevoelige AI-systemen – wat zal resulteren in minder beperkingen op de handel in en het gebruik van AI binnen een enkele markt.